O recente surgimento do ChatGPT da OpenAI (parte da família de modelos de linguagem do transformador pré-treinado generativo) atraiu muita atenção em todo o mundo. É um chatbot lançado em novembro de 2022 e, de acordo com o site da OpenAI, seu “formato de diálogo permite que o ChatGPT responda a perguntas de acompanhamento, admita seus erros, conteste premissas incorretas e rejeite solicitações inadequadas”. O modelo também envolve uma série de limitações sérias, no entanto, que também são mencionadas na página inicial do OpenAI.

Embora modelos de linguagem como o ChatGPT ainda estejam em estágio inicial de desenvolvimento, seu surgimento gerou uma série de discussões e debates avançados entre pesquisadores envolvidos no campo da aquisição da linguagem. De um lado do debate, por exemplo, estão o linguista de renome mundial Noam Chomsky, o professor de lingüística Ian Roberts e o pesquisador de IA Jeffrey Watumull, que, em ensaio publicado na O jornal New York Times em março de 2023, argumentam contra a noção de que programas de inteligência artificial como o ChatGPT seriam capazes de replicar o pensamento e o raciocínio humano, em grande parte porque “esses programas não podem explicar as regras da sintaxe do inglês”, o que torna suas previsões sempre “superficiais e duvidosas. ”

E do outro lado do debate estão aqueles, como o neuropsicólogo Steven T. Piantadosi e o professor de linguística Daniel Everett, que não apenas sugeriram que os modelos de linguagem podem adquirir as estruturas necessárias da linguagem, mas também usaram o lançamento do ChatGPT como uma plataforma de o que lançar um ataque direto à teoria da “gramática universal” de Chomsky, apesar do fato de que ela tem sido apoiada, repetidas vezes, por estudos no campo da aquisição da linguagem.

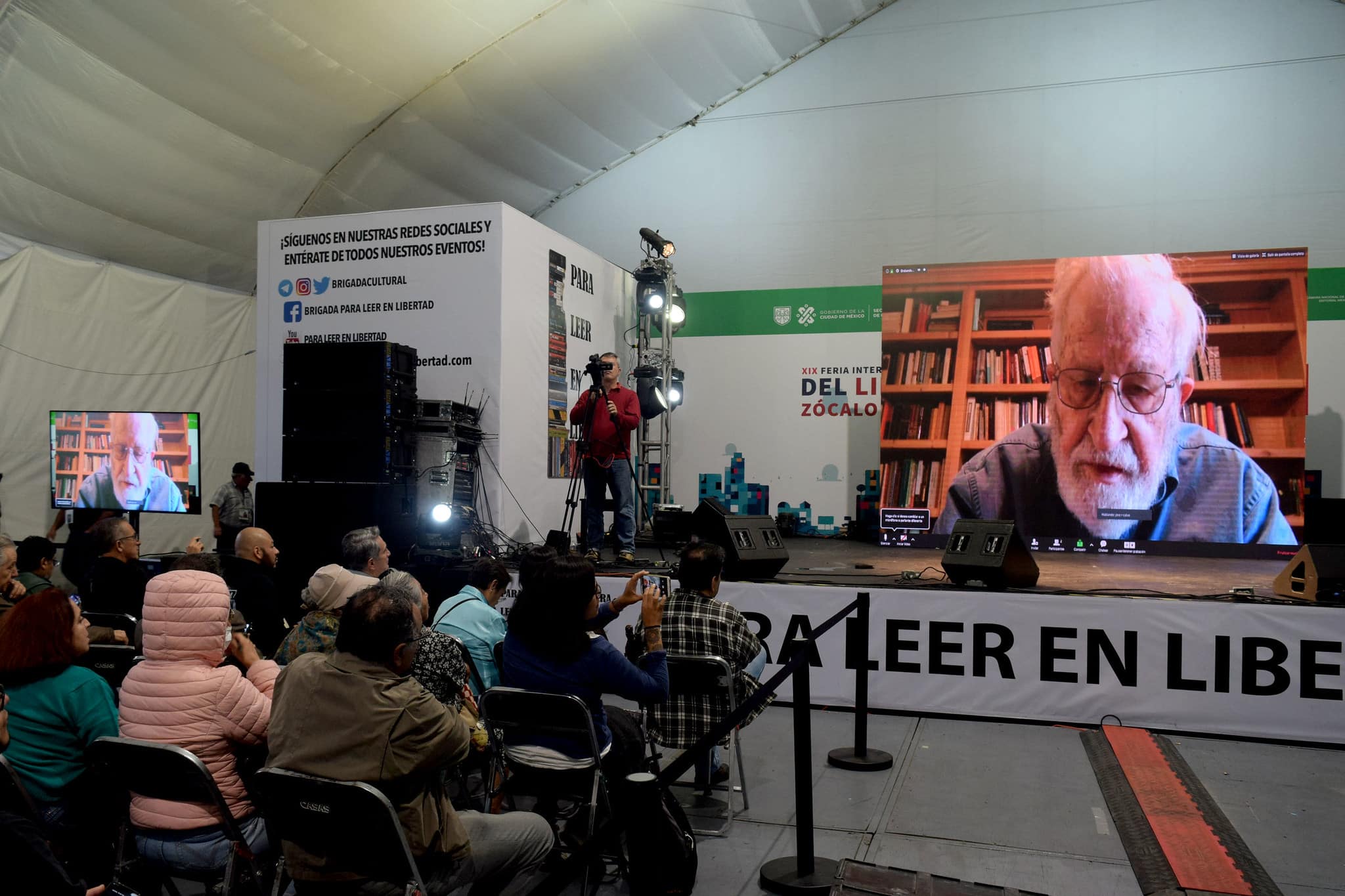

Dito de outra forma, a noção chomskyana de que os humanos são codificados geneticamente com uma gramática universal, uma espécie de quadro estrutural no cérebro que torna possível a capacidade humana para a linguagem, ainda é considerada por muitos no campo da linguística como a explicação mais plausível para a linguagem. aquisição. Então, vamos discutir essas questões, e muito mais, na entrevista que se segue, com um cientista que é reconhecido no meio científico ao redor do mundo como o fundador da linguística moderna, o professor Noam Chomsky. A entrevista foi realizada via e-mail. —Ramin Mirfakhraie

Noam, obrigado por aceitar meu convite para esta entrevista. Como você bem sabe, o recente surgimento de chatbots como o ChatGPT da OpenAI criou um alvoroço global, sobre o qual você, Ian Roberts e Jeffery Watumull escreveram recentemente um ensaio que foi publicado em O jornal New York Times intitulado “A Falsa Promessa do ChatGPT”.

Logo após a publicação deste ensaio, no entanto, vários de seus críticos aproveitaram a oportunidade para desafiar sua teoria da aquisição da linguagem, que foi originalmente formulada em seu livro pioneiro chamado Estruturas Sintáticas (1957). Essa reação o surpreendeu de alguma forma?

Noam Chomsky: Eu vi alguns artigos afirmando que os LLMs desafiam o rico e extenso trabalho dos últimos anos sobre aquisição de linguagem, descrito falsamente como “teoria de Chomsky”, suponho por não estar familiarizado com o campo. Não vi nada que represente um desafio remoto de LLMs para o meu trabalho, ou qualquer trabalho importante sobre aquisição de linguagem que eu conheça.

A falta de familiaridade com o campo pode explicar a natureza falha das críticas de não especialistas ao seu extenso trabalho sobre aquisição da linguagem, mas e as críticas de especialistas à sua pesquisa e teoria, como as apresentadas pelo neuropsicólogo Steven Piantadosi e pelo linguista Daniel Everett?

Em um pedaço intitulado “Os modelos de linguagem moderna refutam a abordagem de Chomsky à linguagem”, por exemplo, Piantadosi afirma que “o aprendizado de máquina moderno subverteu e contornou toda a estrutura teórica da abordagem de Chomsky, incluindo suas principais reivindicações de insights, princípios, estruturas e processos específicos”. Ele afirma ainda que “o desenvolvimento de grandes modelos de linguagem como o GPT-3 desafiou algumas das principais afirmações de Chomsky sobre linguística e a natureza da linguagem” por três motivos:

Primeiro, o fato de que os modelos de linguagem podem ser treinados em grandes quantidades de dados de texto e podem gerar linguagem semelhante à humana sem qualquer instrução explícita sobre gramática ou sintaxe sugere que a linguagem pode não ser tão biologicamente determinada quanto Chomsky afirmou. Em vez disso, sugere que a linguagem pode ser aprendida e desenvolvida por meio da exposição à linguagem e das interações com os outros. Em segundo lugar, o sucesso de grandes modelos de linguagem na execução de várias tarefas de linguagem, como tradução, resumo e resposta a perguntas, desafiou a ideia de Chomsky de que a linguagem é baseada em um conjunto de regras inatas. Em vez disso, sugere que a linguagem é um sistema aprendido e adaptativo que pode ser modelado e aprimorado por meio de algoritmos de aprendizado de máquina. Finalmente, a capacidade dos modelos de linguagem de gerar [sic] linguagem em uma ampla gama de tópicos, apesar de nunca ter visto esses tópicos antes, sugere que a linguagem pode não ser tão baseada em regras quanto Chomsky afirmou. Em vez disso, pode ser mais probabilístico e dependente do contexto, contando com padrões e associações aprendidas com os dados de texto nos quais foi treinado. —Steven Piantadosi

E no mesmo sentido, de forma entrevista com o título “Exclusivo: Linguista diz que o ChatGPT invalidou os ‘princípios inatos da linguagem’ de Chomsky”, Everett afirma que o ChatGPT “falsificou nos termos mais rígidos a afirmação de Chomsky de que os princípios inatos da linguagem são necessários para aprender um idioma. O ChatGPT mostrou que, sem quaisquer princípios rígidos de gramática ou linguagem, este programa, juntamente com dados massivos (Large Language Models), pode aprender um idioma.”

Essas afirmações são válidas em sua opinião?

NC: Nenhum deles indica familiaridade com o campo da aquisição da linguagem. Mesmo a familiaridade mais superficial revela que crianças muito pequenas já possuem um rico domínio dos princípios básicos de sua linguagem, muito além do que exibem na performance. O trabalho de Lila Gleitman, Stephen Crain, Kenneth Wexler e muitos outros deixa isso bem claro. Muitos detalhes foram descobertos sobre as formas específicas pelas quais a aquisição ocorre também nos anos posteriores. Os estudos estatísticos cuidadosos de Charles Yang sobre o material disponível para crianças pequenas mostram que as evidências são muito escassas, especialmente quando os efeitos da lei de Zipf na distribuição de frequência de classificação são considerados.

É um absurdo além da discussão acreditar que qualquer luz possa ser lançada sobre esses processos por LLMs, que examinam quantidades astronômicas de dados para encontrar regularidades estatísticas que permitem uma previsão justa da próxima palavra provável em uma sequência com base no enorme corpus que analisam.

O absurdo é de fato um problema menor. Mais fundamentalmente, é óbvio que esses sistemas, qualquer que seja seu interesse, são incapazes, em princípio, de lançar luz sobre a aquisição da linguagem por humanos. A razão é que eles se saem tão bem com idiomas impossíveis que os humanos não podem adquirir da maneira das crianças (se é que o fazem).

É como se um físico propusesse uma “teoria” dizendo “aqui tem muita coisa que acontece e muita coisa que não pode acontecer e não consigo fazer distinção entre elas”.

Piantadosi está familiarizado com os LLMs, mas, como muitos outros, não demonstra consciência desses problemas fundamentais. Everett simplesmente faz afirmações infundadas que não merecem atenção.

O próprio fato de atribuírem as teorias a mim revela falta de familiaridade com o rico e bem desenvolvido campo de aquisição da linguagem.

Talvez a falta de familiaridade desses críticos com o campo da aquisição da linguagem decorra de um problema mais fundamental; ou seja, uma visão potencialmente distorcida de sua teoria da aquisição da linguagem, que teve muita influência, para dizer o mínimo, em muito do que ocorreu no campo em termos de teorização.

Então, novamente, isso pode estar relacionado a uma questão que o psicólogo de Harvard Steven Pinker levantou em 2016. Em uma entrevista com John Horgan, publicada pela Scientific American Blogs sob o título “A teoria da linguagem de Chomsky está errada? Pinker Pesa no Debate,” ele fala sobre a natureza obscura da “teoria da linguagem de Chomsky” e como seu conceito de “Gramática Universal” é ambíguo em termos do que ele consiste.

Seria extremamente útil, acredito, se você pudesse neste ponto discutir brevemente sua teoria da aquisição da linguagem, especialmente porque ela passou por várias revisões desde sua formulação original.

NC: É fácil descobrir a que se refere a “teoria da linguagem de Chomsky”: publicação após publicação fornecendo detalhes. Parece haver uma concepção estranha de que deveria haver uma teoria fixa e imutável da natureza da linguagem. Não há, não mais do que nas ciências em geral.

Na aquisição da linguagem – ou qualquer processo de crescimento e desenvolvimento – três fatores estão envolvidos: (1) estrutura inata, (2) estímulos externos, (3) leis da natureza.

Qualquer abordagem sensata à aquisição da linguagem procurará determinar como eles interagem para produzir a transição do estado inicial (1) para o estado relativamente estável alcançado. Houve um progresso considerável em todas as três áreas. A estrutura de Princípios e Parâmetros forneceu a primeira esperança real para uma explicação viável da transição que explicaria a diversidade de línguas humanas possíveis. Isso inspirou uma grande quantidade de trabalhos destinados a determinar como uma criança pode pesquisar de forma viável através do espaço de parâmetros para produzir uma língua (ou línguas) particular. Entre as principais contribuições, o trabalho recente de Ian Roberts mostra como processos cognitivos muito simples podem alcançar resultados altamente significativos, testados com milhares de linguagens tipologicamente diferentes. O trabalho experimental mostrou que crianças muito novas dominam os fundamentos da linguagem, muito além do que exibem no desempenho, e estudos estatísticos cuidadosos revelam que os dados disponíveis para eles são escassos e, em casos cruciais, inexistentes.

Meu próprio trabalho se concentrou em (1) e (3), com princípios de eficiência computacional considerados como leis da natureza – naturais para um sistema computacional como a linguagem. Não posso revisar o curso deste trabalho aqui: há amplo material impresso, até o presente.

Para esclarecer um ponto terminológico, muitas vezes mal compreendido, o termo técnico e (“gramática universal”) refere-se à teoria de (1), a teoria da faculdade humana da linguagem, aparentemente compartilhada pela espécie e com propriedades básicas não encontradas em outros organismos, portanto, uma verdadeira propriedade da espécie.

Voltando aos LLMs, com a abordagem que você descreveu acima em mente, podemos dizer que tais modelos algum dia poderão substituir a lingüística para a compreensão da faculdade humana da linguagem?

NC: Seu desenho básico garante que isso seja impossível, pelos dois motivos que mencionei: a pequena falha, que torna a proposta absurda; a falha principal, que o torna impossível em princípio.

Finalmente, você acha que deveria haver algum tipo de regulamentação governamental de modelos de linguagem como o ChatGPT, em termos de, digamos, questões de privacidade ou segurança de dados, semelhante ao que aconteceu recentemente em Itália?

NC: Como você sabe, há uma petição circulando pedindo uma moratória no desenvolvimento desses sistemas, assinada por uma grande variedade de profissionais proeminentes. E houve pedidos de regulamentação governamental. As ameaças são reais o suficiente. Eu francamente duvido que haja alguma maneira prática de contê-los. O meio mais eficaz em que posso pensar é a única maneira de conter a disseminação de doutrinas e ideologias maliciosas: educação em pensamento crítico, organização para encorajar a deliberação e modos de autodefesa intelectual.

Obrigado, Noam, pelo seu tempo e informações valiosas.

Noam Chomsky é professora laureada do Departamento de Linguística da Faculdade de Ciências Sociais e Comportamentais e da Cátedra Agnese Nelms Haury do Programa Agnese Nelms Haury em Meio Ambiente e Justiça Social da Universidade do Arizona. Ele recebeu inúmeros prêmios, escreveu mais de 100 livros sobre uma ampla gama de tópicos e é reconhecido mundialmente como o fundador da lingüística moderna. Ele também é um renomado comentarista político e um dos intelectuais públicos mais influentes do mundo. Seu último livro é Quem governa o mundo? (Metropolitan Books, The American Empire Project, 2016).

Ramin Mirfakhraie é um sociólogo baseado nos Estados Unidos. Seus interesses de pesquisa incluem globalização capitalista e política internacional. Ele é PhD pela Universidade de Warwick, no Reino Unido.

Fonte: mronline.org